« Aujourd'hui, en plus de célébrer la première année de Microsoft Copilot, nous avons annoncé plusieurs fonctionnalités de Copilot qui commencent à être déployées » indiquait Microsoft ce 5 décembre. Voici donc un aperçu plus détaillé de certaines de ces fonctionnalités.

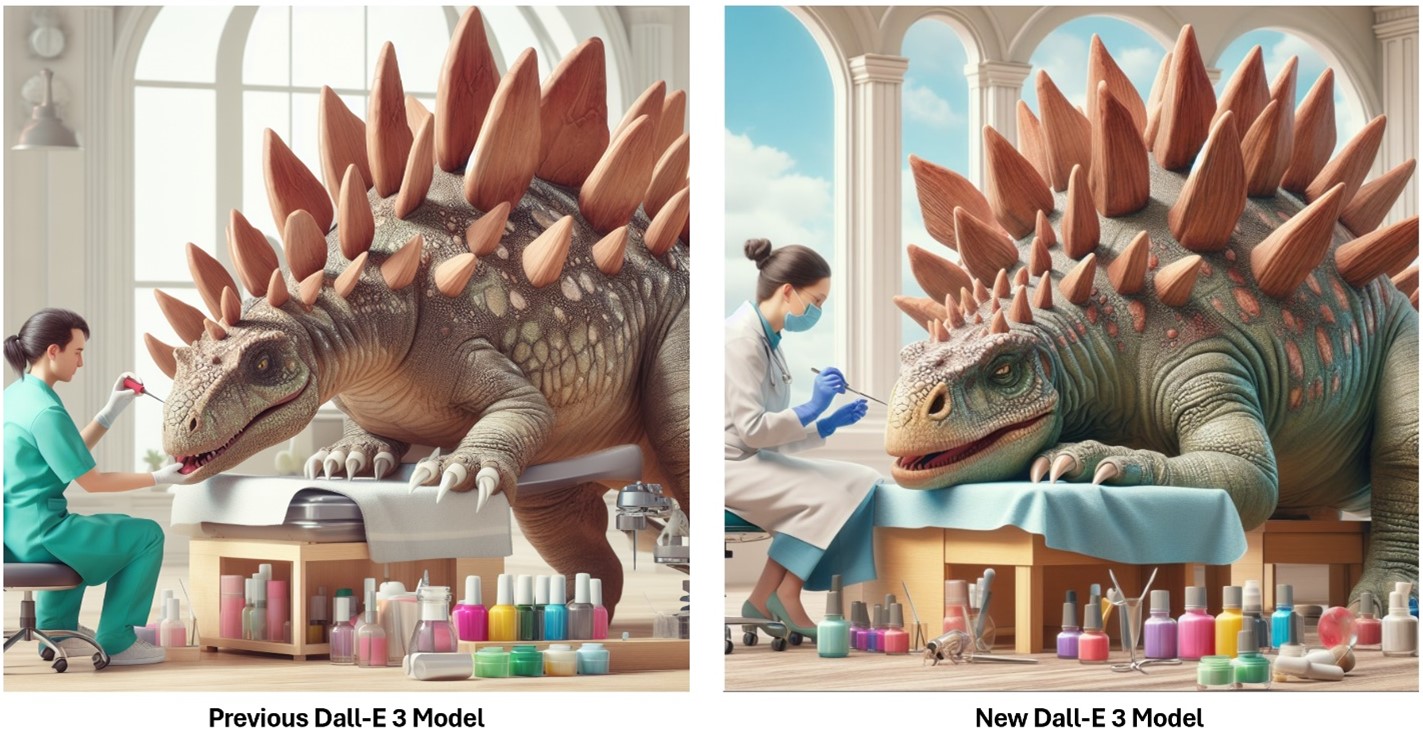

Tout d’abord, il y a GPT-4 Turbo. « Bientôt, Copilot pourra générer des réponses en utilisant le dernier modèle d'OpenAI, GPT-4 Turbo, ce qui vous permettra de vous attaquer à des tâches plus complexes et plus longues telles que l'écriture de code et plus encore » indique la firme sur son blog. Pour rappel, cette version Turbo a été dévoilée en novembre dernier lors de la conférence Dev Day d’OpenAI. Ce LLM se caractérise par trois éléments : la longueur du contexte, des connaissances plus à jour et le prix. Pour l’heure, ce modèle est testé par certains utilisateurs de Copilot et sera intégré à l’outil de façon définitive dans les semaines à venir. Autre nouveauté, le modèle DALL-E 3. « Vous pouvez désormais utiliser Copilot pour créer des images d'une qualité encore plus élevée et d'une plus grande précision grâce au modèle DALL-E 3 mis à jour ». Les utilisateurs peuvent y accéder dès maintenant via la page bing.com/create ou en demandant à Copilot de créer une image. Le modèle apporte clairement sa spécificité avec des détails plus réalistes.

Ici, un stégosaure photoréaliste dont les plaques osseuses sont entretenues par un salon de manucure. (Crédit : Microsoft)

Le traitement multimodal fait également son apparition dans Copilot avec l’outil Search Grounding. Ce dernier combine « la puissance de GPT-4 avec la recherche d'images Bing et les données de recherche sur le web » affirme la firme de Redmond. Objectif : offrir une meilleure compréhension de l'image pour les requêtes. Selon les mots de la firme, « un système multimodal traditionnel serait en mesure de décrire l'image de manière générique, mais grâce à la recherche, nous sommes en mesure d'identifier la version exacte et le jour de son lancement ». Microsoft a donc fait bénéficier de cette mise à jour Prometheus, son modèle d'IA propriétaire qui combine l'index, le classement et les résultats des réponses de Bing, récents et complets, avec les capacités de raisonnement créatif des modèles GPT les plus avancés d'OpenAI. A noter que cette fonction n’est pas encore disponible.

Un interprète de code fait également partie de l'actualisation. Cette fonctionnalité aide l’utilisateur à effectuer des tâches complexes telles que des calculs plus précis, du codage, de l'analyse de données, de la visualisation, des mathématiques, etc. « Copilot écrira le code pour répondre à vos demandes complexes en langage naturel, exécutera ce code dans un environnement de type "bac à sable" et utilisera les résultats pour vous donner des réponses de meilleure qualité ». Il est également possible de télécharger des fichiers vers et depuis Copilot, afin de travailler avec ses propres données et son propre code, ainsi qu'avec les résultats de recherche de Bing. Code Interpreter effectue des tâches de science des données en écrivant puis en exécutant du code Python dans Azure Container Apps, ajoute la firme. Pour l’heure, l’outil est en phase de test au sein d’un petit groupe d'utilisateurs sélectionnés et devrait être proposé à tous prochainement.

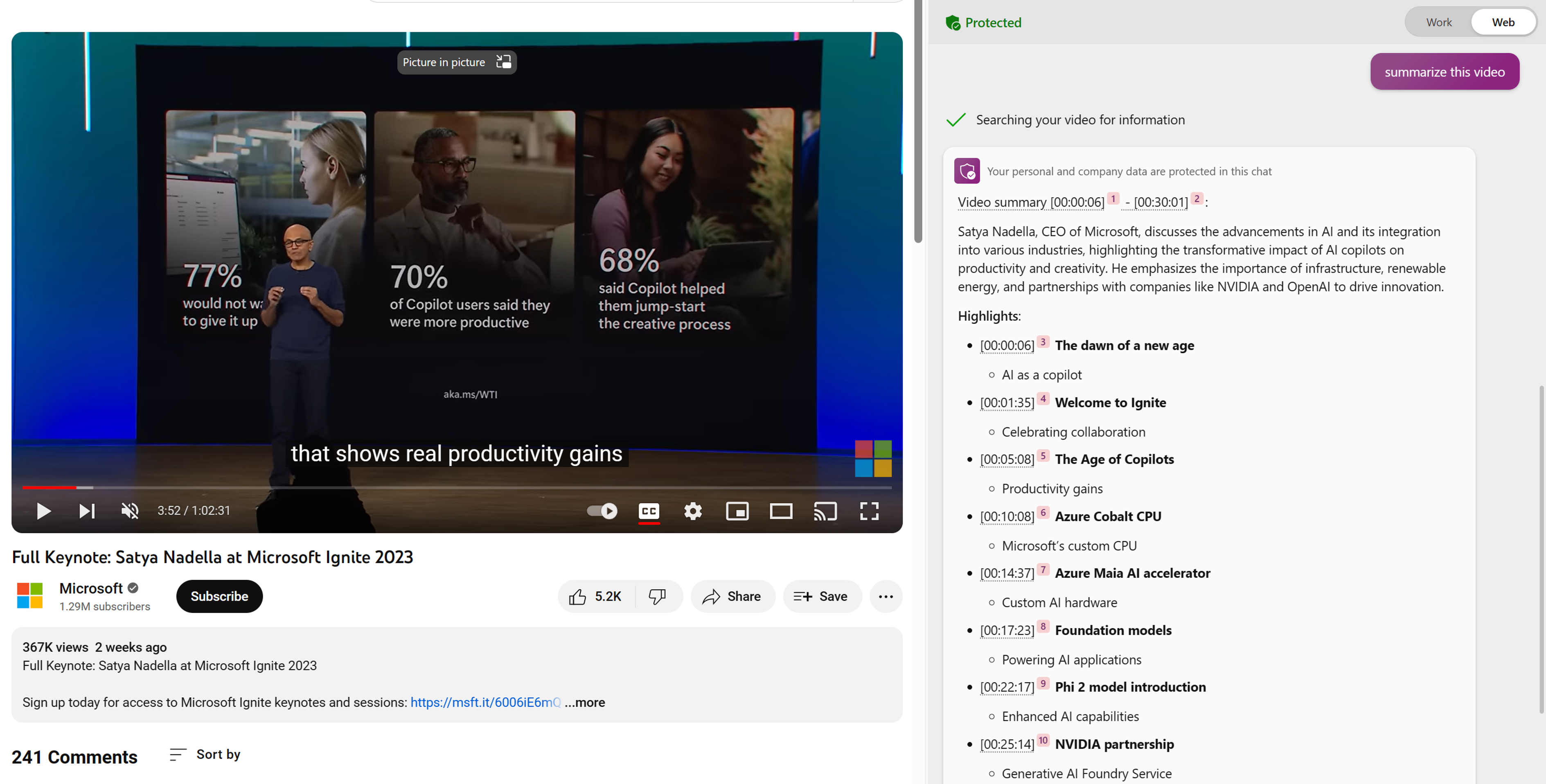

Enfin, la mise à jour apporte un outil de compréhension des vidéos avec un système de questions-réponses dans Edge. « Vous pouvez désormais résumer ou poser des questions sur une vidéo que vous regardez dans Edge. Par exemple, si vous regardez la vidéo YouTube de la dernière conférence Ignite de Satya Nadella, vous pouvez demander à Copilot de la résumer pour vous » indique Microsoft.

Cet outil aide notamment dans la recherche d'un passage précis d'une vidéo. (Crédit : Microsoft)