Midjourney: comment savoir si une image a été créée avec une intelligence artificielle?

comment savoir si une image a été créée avec une intelligence artificielle?

Emmanuel Macron en éboueur, le pape en doudoune... Différencier les images générées par IA de la réalité devient de plus en plus difficile. Voici quelques conseils pour éviter de se faire avoir.

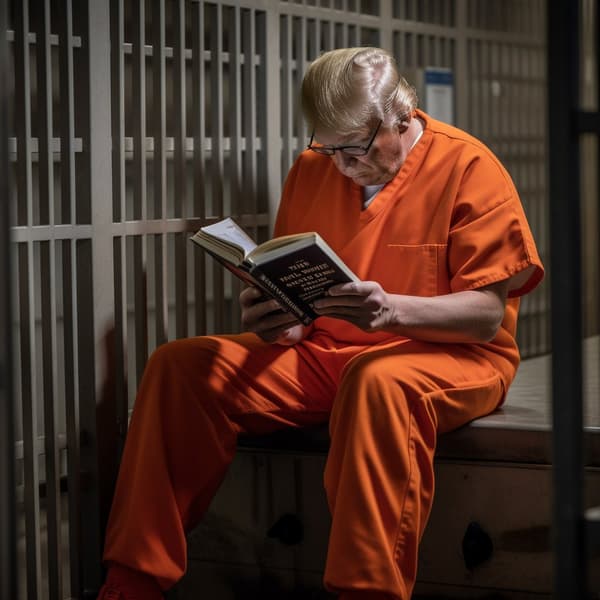

Emmanuel Macron a-t-il vraiment été vu en train de ramasser les poubelles à Paris? Donald Trump a-t-il vraiment été arrêté? Le pape a-t-il été photographié avec une doudoune? À en croire certaines images largement reprises sur les réseaux sociaux, oui.

Toutes ces photos virales ont en fait été générées par une intelligence artificielle: Midjourney. En quelques secondes, elle peut générer des images bluffantes de réalisme à partir d’une simple description écrite. Mais comment faire la différence entre ces images et de véritables photos? Voici quelques conseils pour éviter de vous faire avoir par les IA.

· Regarder les mains

Au premier coup d'œil, la plupart des images virales de ces derniers jours paraissent réelles. Mais le premier moyen de faire la différence, c’est simplement de s’arrêter et de regarder d’un peu plus près.

Par exemple, cette image censée montrer l'arrestation de Donald Trump. En la voyant passer rapidement sur les réseaux sociaux, l'image peut passer pour un cliché pris dans le feu de l'action. Mais si on zoome, certains détails mettent rapidement la puce à l'oreille.

Par exemple, les mains à droite de l'image: certaines ont seulement 4 doigts, ou ont l'air étrangement translucides.

Et ce n'est pas un cas isolé. Même si elles se sont améliorées dernièrement, les IA comme Midjourney ont encore des problèmes avec les mains ou les dents, y compris dans la photo du pape François qui a tant fait parler. Pour savoir si une image a été générée par IA, c'est la première chose à regarder.

Des textes illogiques

Un autre point faible actuel de ces IA, c'est le texte. Quand elles essaient de reproduire des panneaux, des pancartes, des enseignes... Elles créent souvent des suite de symboles inexistants ou complètement illogiques. Comme dans cette image censée représenter Donald Trump en prisonnier, en train de lire un livre indéchiffrable.

· Repérer les détails incohérents

Mais certaines images créées par IA ne présentent ni texte étrange ni mains ratées. Il faut donc sortir la loupe et partir à la recherche du détail incohérent.

Car il y en a presque toujours un: une forme étrange, comme dans cette image censée montrer un policier en train d'enlacer une manifestante, avec un feu de circulation bicolore en arrière-plan...

Des personnes à l'arrière-plan mal définies ou dont le visage semble avoir fondu...

Ou des textures irréelles, avec "le grain de la photo qui lui donne une texture plate", comme l'explique au Figaro Tina Nikoukhah, docteur en traitement d'images à l'École normale supérieure de Paris-Saclay. De quoi donner aux personnages centraux des airs de statue de cire.

· Faire une recherche par image

Une autre méthode simple: utiliser la recherche inversée sur l'image. La personne qui l'a publiée à l'origine a pu préciser qu'il s'agissait d'une image générée par IA. Si elle n'apparaît quasiment nulle part ailleurs, ou dans des publications qui n'expliquent jamais sa provenance, cela peut vous mettre la puce à l'oreille. Et si des articles l'identifient déjà comme la création d'une IA, il reste peu de doutes sur son origine.

Enfin, certaines IA laissent volontairement une trace de leur passage. Dall-E, par exemple, ajoute toujours une signature sous la forme d'une bande multicolore en bas à droite de ses créations.

Mais ce n'est pas parce que cette bande est absente que l'image est authentique: les autres IA comme Midjourney ne laissent pas de trace aussi visible, et le créateur de l'image peut la redimensionner ou la modifier pour cacher cette signature. Dall-E n'est de toute façon pas l'IA la plus utilisée pour créer des "fakes" réalistes.

· Toujours rester vigilant

Ces méthodes, déjà limitées, pourraient bientôt être dépassées. Vu l'impressionnante progression de ces IA ces derniers mois, les défauts sur les doigts ou les dents pourraient vite devenir de l'histoire ancienne.

"Ces erreurs seront rapidement corrigées, si elles ne le sont pas déjà", s'inquiète Tina Nikoukhah, docteur en traitement d'images à l'École normale supérieure de Paris-Saclay.

La chercheuse explique que la solution idéale serait d'obliger toutes les IA à apposer une signature plus ou moins visible à l'œil nu sur leurs créations. Mais le défi est de taille: il faudrait trouver une signature qui ne serait pas brouillée par quelques modifications basiques de l'image, imposer cette mesure aux géants de l'IA basés à l'étranger, ainsi qu'aux logiciels "open source" de plus en plus nombreux et que tout le monde peut modifier à sa guise. La méthode la plus efficace reste donc encore la vigilance humaine.

Source